Tag: SEO

Mitte der 1990er Jahre fingen die anstehenden Suchmaschinen an, das frühe Web zu ordnen. Die Seitenbesitzer erkannten flott den Wert einer nahmen Positionierung in den Resultaten und recht bald fand man Betrieb, die sich auf die Aufbesserung qualifitierten.

In den Anfängen bis zu diesem Zeitpunkt die Aufnahme oft zu der Übermittlung der URL der entsprechenden Seite an die vielfältigen Search Engines. Diese sendeten dann einen Webcrawler zur Analyse der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetseite auf den Web Server der Recherche, wo ein zweites Angebot, der allgemein so benannte Indexer, Infos herauslas und katalogisierte (genannte Ansprüche, Links zu weiteren Seiten).

Die neuzeitlichen Modellen der Suchalgorithmen basierten auf Infos, die durch die Webmaster eigenständig existieren werden konnten, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Netz wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht über den Content einer Seite, doch setzte sich bald heraus, dass die Benutzung der Hinweise nicht vertrauenswürdig war, da die Wahl der eingesetzten Schlüsselworte durch den Webmaster eine ungenaue Beschreibung des Seiteninhalts widerspiegeln konnte. Ungenaue und unvollständige Daten in den Meta-Elementen vermochten so irrelevante Websites bei einzigartigen Benötigen listen.[2] Auch versuchten Seitenersteller verschiedenartige Punkte in des HTML-Codes einer Seite so zu beeinflussen, dass die Seite stärker in Suchergebnissen gelistet wird.[3]

Da die späten Suchmaschinen im WWW sehr auf Punkte abhängig waren, die ausschließlich in Händen der Webmaster lagen, waren sie auch sehr labil für Missbrauch und Manipulationen im Ranking. Um gehobenere und relevantere Testurteile in den Serps zu bekommen, mussten wir sich die Operatoren der Suchmaschinen im WWW an diese Faktoren adjustieren. Weil der Ergebnis einer Suchseiten davon abhängig ist, besondere Ergebnisse der Suchmaschine zu den inszenierten Keywords anzuzeigen, vermochten untaugliche Vergleichsergebnisse dazu führen, dass sich die Mensch nach anderen Chancen für den Bereich Suche im Web umgucken. Die Antwort der Suchmaschinen fortbestand in komplexeren Algorithmen beim Positionierung, die Punkte beinhalteten, die von Webmastern nicht oder nur kompliziert beherrschbar waren. Larry Page und Sergey Brin gestalteten mit „Backrub“ – dem Urahn von Yahoo – eine Suchmaschine, die auf einem mathematischen Matching-Verfahren basierte, der mit Hilfe der Verlinkungsstruktur Seiten gewichtete und dies in Rankingalgorithmus eingehen ließ. Auch zusätzliche Suchmaschinen im Internet bedeckt in der Folgezeit die Verlinkungsstruktur bspw. wohlauf der Linkpopularität in ihre Algorithmen mit ein.

Die Suchmaschine

Mitteilung: What’s Robots.txt & Easy methods to Create Robots.txt File? | search engine optimization tutorial

Meldung: The right way to create your Amazon product listing step-by-step – Straightforward web optimization & optimization tutorial 2022

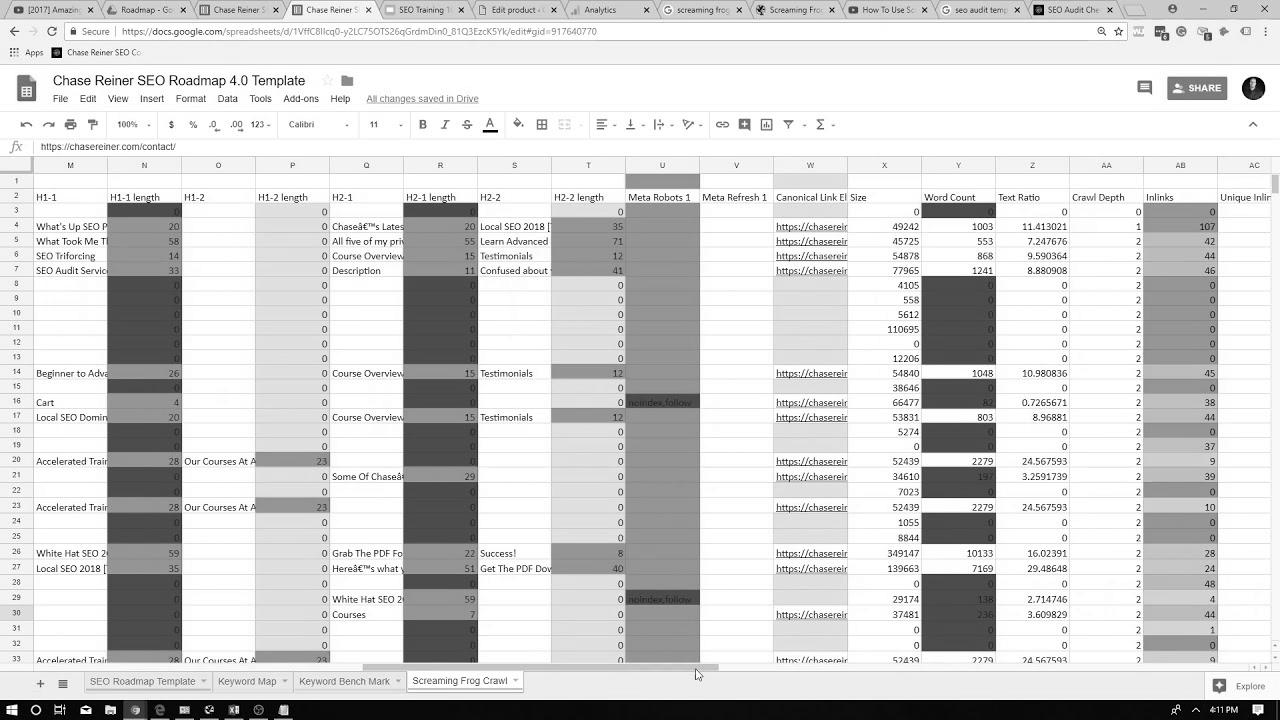

How To Create The Final search engine optimization Audit (2018 Up to date)

Meldung: The right way to make BEST Thumbnails for YouTube Movies – website positioning Search Engine Optimization Methods

![Lawless Lawyer – EP13 | Lee Joon Gi & {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Ye Ji Make Up [Eng Sub] Lawless Lawyer – EP13 | Lee Joon Gi & {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Ye Ji Make Up [Eng Sub]](/wp-content/uploads/2022/06/1655091739_maxresdefault.jpg)

Lawless Lawyer – EP13 | Lee Joon Gi & Web optimization Ye Ji Make Up [Eng Sub]

How To Create Content That Ranks Excessive In Search Engines – SPPC search engine marketing Tutorial #8

Mehr zu: YouTube Advertising Course 2022 🔥 | Complete YouTube web optimization Tutorial & Tips

Mitteilung: How can I make SEO and Traffic Generation Easier?

Mehr zu: Key phrase Research for Ecommerce Website/Online Store | Ecommerce search engine optimisation