The best way to Make the website positioning Case to Small Companies – Whiteboard Friday

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

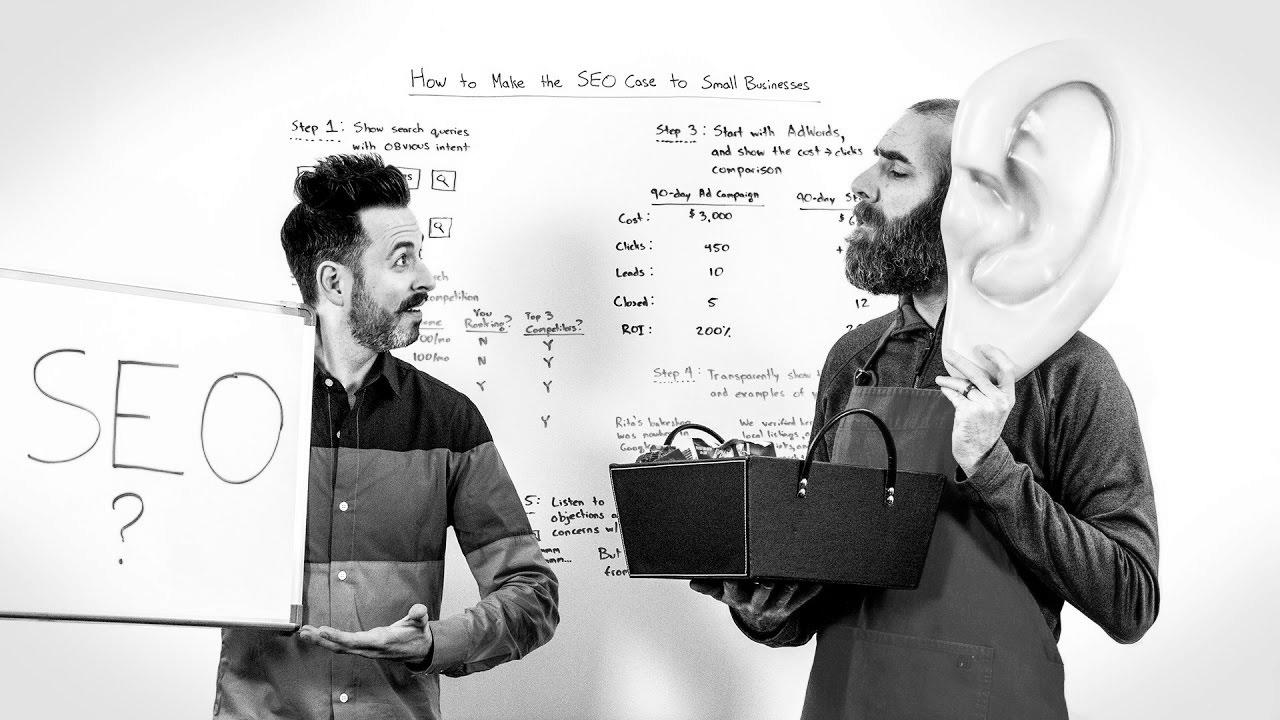

Make Search engine marketing , Learn how to Make the web optimization Case to Small Companies - Whiteboard Friday , , _z8dFyfks5o , https://www.youtube.com/watch?v=_z8dFyfks5o , https://i.ytimg.com/vi/_z8dFyfks5o/hqdefault.jpg , 1743 , 5.00 , https://moz.com/blog/make-seo-case-small-businesses-whiteboard-friday Belief within the process can be the make-or-break factor ... , 1483911618 , 2017-01-08 22:40:18 , 00:09:11 , UCs26XZBwrSZLiTEH8wcoVXw , Moz , 9 , , [vid_tags] , https://www.youtubepp.com/watch?v=_z8dFyfks5o , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=_z8dFyfks5o, #search engine marketing #Case #Small #Companies #Whiteboard #Friday [publish_date]

#search engine optimization #Case #Small #Businesses #Whiteboard #Friday

https://moz.com/blog/make-seo-case-small-businesses-whiteboard-friday Belief within the course of will be the make-or-break factor ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die allerersten Suchmaschinen im Internet an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten direkt den Wert einer lieblings Listung in Resultaten und recht bald entstanden Betriebe, die sich auf die Verfeinerung ausgebildeten. In Anfängen bis zu diesem Zeitpunkt die Aufnahme oft über die Übermittlung der URL der passenden Seite in puncto verschiedenartigen Suchmaschinen im Netz. Diese sendeten dann einen Webcrawler zur Auswertung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetpräsenz auf den Web Server der Suchseite, wo ein zweites Softwaresystem, der so genannte Indexer, Informationen herauslas und katalogisierte (genannte Ansprüche, Links zu anderen Seiten). Die frühen Modellen der Suchalgorithmen basierten auf Informationen, die durch die Webmaster eigenständig gegeben wurden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen wie ALIWEB. Meta-Elemente geben eine Übersicht über den Thema einer Seite, doch stellte sich bald heraus, dass die Nutzung der Vorschläge nicht ordentlich war, da die Wahl der angewendeten Schlagworte durch den Webmaster eine ungenaue Erläuterung des Seiteninhalts reflektieren konnte. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Webseiten bei besonderen Ausschau halten listen.[2] Auch versuchten Seitenersteller diverse Attribute innerhalb des HTML-Codes einer Seite so zu beherrschen, dass die Seite überlegen in den Resultaten gefunden wird.[3] Da die damaligen Suchmaschinen sehr auf Gesichtspunkte angewiesen waren, die ausschließlich in Koffern der Webmaster lagen, waren sie auch sehr instabil für Schindluder und Manipulationen im Ranking. Um höhere und relevantere Ergebnisse in den Serps zu erhalten, mussten sich die Anbieter der Suchmaschinen im Internet an diese Ereignisse einstellen. Weil der Gelingen einer Search Engine davon abhängt, wichtigste Suchergebnisse zu den inszenierten Keywords anzuzeigen, vermochten unpassende Urteile zur Folge haben, dass sich die Nutzer nach ähnlichen Chancen zur Suche im Web umblicken. Die Auflösung der Internet Suchmaschinen fortbestand in komplexeren Algorithmen fürs Ranking, die Aspekte beinhalteten, die von Webmastern nicht oder nur nicht leicht beherrschbar waren. Larry Page und Sergey Brin entwickelten mit „Backrub“ – dem Urahn von Bing – eine Search Engine, die auf einem mathematischen Algorithmus basierte, der anhand der Verlinkungsstruktur Websites gewichtete und dies in Rankingalgorithmus einfließen ließ. Auch zusätzliche Suchmaschinen im Internet relevant pro Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein. Yahoo