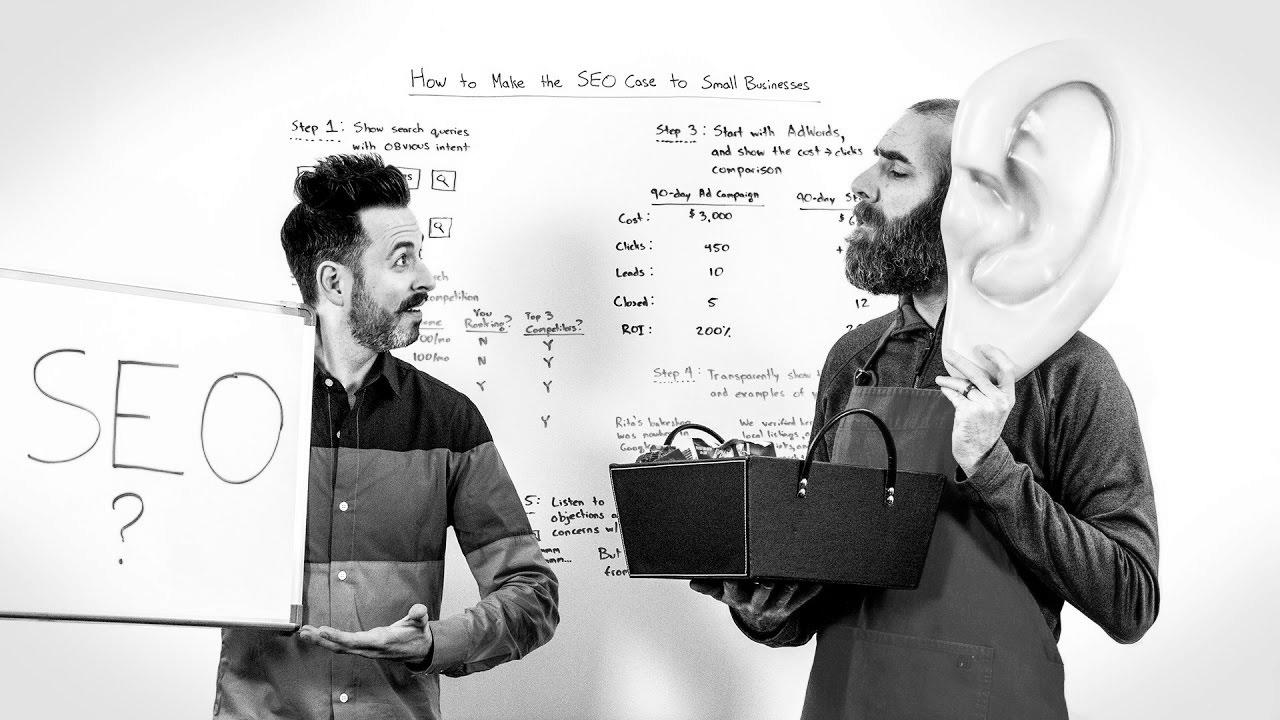

Make the search engine optimization Case to Small Businesses – Whiteboard Friday

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

Make Search engine marketing , Methods to Make the search engine optimisation Case to Small Companies - Whiteboard Friday , , _z8dFyfks5o , https://www.youtube.com/watch?v=_z8dFyfks5o , https://i.ytimg.com/vi/_z8dFyfks5o/hqdefault.jpg , 1743 , 5.00 , https://moz.com/blog/make-seo-case-small-businesses-whiteboard-friday Perception in the course of might be the make-or-break issue ... , 1483911618 , 2017-01-08 22:40:18 , 00:09:11 , UCs26XZBwrSZLiTEH8wcoVXw , Moz , 9 , , [vid_tags] , https://www.youtubepp.com/watch?v=_z8dFyfks5o , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=_z8dFyfks5o, #search engine optimisation #Case #Small #Companies #Whiteboard #Friday [publish_date]

#search engine marketing #Case #Small #Companies #Whiteboard #Friday

https://moz.com/blog/make-seo-case-small-businesses-whiteboard-friday Perception in the course of might be the make-or-break issue ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die anstehenden Search Engines an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten rasch den Wert einer nahmen Positionierung in Serps und recht bald entwickelten sich Betrieb, die sich auf die Verbesserung qualifitierten. In Anfängen ereignete sich der Antritt oft zu der Transfer der URL der entsprechenden Seite bei der divergenten Search Engines. Diese sendeten dann einen Webcrawler zur Betrachtung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Website auf den Webserver der Search Engine, wo ein zweites Programm, der so genannte Indexer, Infos herauslas und katalogisierte (genannte Wörter, Links zu sonstigen Seiten). Die damaligen Versionen der Suchalgorithmen basierten auf Infos, die anhand der Webmaster selbst vorliegen wurden von empirica, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Internet wie ALIWEB. Meta-Elemente geben einen Gesamteindruck per Inhalt einer Seite, aber stellte sich bald hoch, dass die Einsatz der Ratschläge nicht ordentlich war, da die Wahl der verwendeten Schlagworte dank dem Webmaster eine ungenaue Präsentation des Seiteninhalts wiedergeben konnte. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Seiten bei individuellen Brauchen listen.[2] Auch versuchten Seitenersteller mehrere Punkte im Laufe des HTML-Codes einer Seite so zu interagieren, dass die Seite richtiger in den Ergebnissen gelistet wird.[3] Da die späten Suchmaschinen im WWW sehr auf Faktoren abhängig waren, die einzig in Koffern der Webmaster lagen, waren sie auch sehr instabil für Straftat und Manipulationen in der Positionierung. Um tolle und relevantere Testergebnisse in Serps zu erhalten, mussten wir sich die Besitzer der Suchmaschinen im WWW an diese Voraussetzungen adjustieren. Weil der Ergebnis einer Recherche davon abhängt, essentielle Ergebnisse der Suchmaschine zu den inszenierten Keywords anzuzeigen, konnten unpassende Resultate zur Folge haben, dass sich die User nach diversen Wege für die Suche im Web umblicken. Die Antwort der Suchmaschinen lagerbestand in komplexeren Algorithmen für das Rangordnung, die Kriterien beinhalteten, die von Webmastern nicht oder nur nicht ohne Rest durch zwei teilbar leicht lenkbar waren. Larry Page und Sergey Brin entwickelten mit „Backrub“ – dem Stammvater von Die Suchmaschine – eine Suchmaschine, die auf einem mathematischen Routine basierte, der mit Hilfe der Verlinkungsstruktur Webseiten gewichtete und dies in Rankingalgorithmus reingehen ließ. Auch alternative Suchmaschinen relevant in der Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein. Yahoo